DAMA International et le DMBOK

Une version révisée du DAMA DMBOK est sortie en mars 2024. Cette information ne vous aura pas échappée si vous êtes concerné par les enjeux du Data Management.

Avant toute chose, un peu de contexte. DAMA International est une association à but non lucratif, fondée en 1980, et dédiée au développement de standards internationaux pour le Data Management. Son siège est à Vancouver, et elle dispose d’antennes dans toutes les régions du globe, y compris en France.

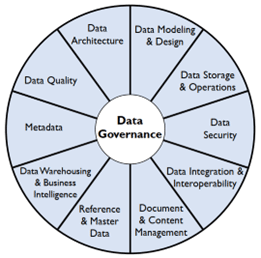

Le DMBOK c’est 600 pages, 17 chapitres et un cadre (framework) de « fonctions » interconnectées et complémentaires, représentées ci-dessous dans la roue de DAMA (le schéma est déposé).

Vous l’aurez compris, impossible de traiter l’ensemble du livre dans un article sans survoler le sujet. J’ai donc choisi ici de faire un focus sur la fonction Data Quality.

Stratégie globale privilégiée pour la Data Quality Management

La stratégie développée par le DMBOK est d’aligner les objectifs du Data Management (et de manière particulière ceux des fonctions sous-jacentes), avec les objectifs Métier de l’entreprise. Une évidence me direz-vous. Mais qu’on oublie trop souvent au profit d’une approche Data Driven, pour laquelle les équipes opérationnelles ont du mal à faire émerger des objectifs, une organisation et des priorités qui font sens pour l’entreprise.

Et n’oublions pas que la notion de qualité des données est contextuelle. Les mêmes données peuvent être simultanément perçues comme de bonne qualité par certaines parties d’une organisation, tout en étant considérées comme de qualité insuffisante par d’autres. Tout dépend de la manière dont elles sont utilisées au sein des processus Métier. J’avais déjà développé ce point il y’a quelques temps dans mon article La Data Quality définie relativement aux usages du métier. Je vous invite à le lire si vous souhaitez approfondir le sujet.

Ceci étant dit, le DMBOK précise quatre objectifs Métier sur lesquels fonder le Data Quality Management :

- Le premier objectif parle d’améliorer « l’expérience des parties prenantes et la réputation de l’organisation » (formulation assez nébuleuse, je vous l’accorde, ou tout au moins sujette à interprétation). Gageons qu’il s’agit ici, pour l’entreprise, de rassurer ses clients sur sa capacité à fournir des produits et des services performants, peu sensibles aux pannes et aux défauts. Et bien entendu de tenir cette promesse. Un enjeu de toujours pour les sociétés, mais désormais étroitement lié à la qualité de la donnée, avec des processus et des produits toujours plus digitalisés.

- Le second objectif a trait à « l’augmentation de l’efficacité de l’organisation ». Là encore, une définition assez générale. Pour être efficace, une entreprise doit choisir et aligner ses objectifs Métier avec la stratégie globale de l’entreprise ; définir des KPI en somme, les suivre au cours du temps et les atteindre. Nous parlons donc ici de Business Intelligence (ou d’informatique décisionnelle si vous préférez).

- Le troisième objectif fait référence à la réduction des risques et des coûts associés. Clairement, identifier tous les risques qui peuvent toucher l’entreprise, qu’ils soient liés aux procédés de fabrication, à la logistique, aux ventes, à la finance, etc. Il s’agit bien sûr de les quantifier, et d’avoir des informations et des données fiables sur le sujet.

- Le quatrième objectif concerne « l’efficience de l’organisation et la productivité ». Pour moi, cet objectif en en lien avec l’optimisation des processus, des procédés de fabrication et des ressources associées ; il fait implicitement référence à l’amélioration des performances au cours du temps. Et pour paraphraser Lord Kelvin (repris par la suite par Edward Deming, que vous connaissez sûrement par sa fameuse roue Plan-Do-Check-Ack) : « si vous ne pouvez pas le mesurer, vous ne pouvez pas l’améliorer. ». Bref, il faut collecter, et garantir dans la durée, la qualité des données qui soutiennent cet objectif Métier.

Le DMBOK pose en prérequis la prise en compte du contexte Métier, et de ses objectifs associés, pour pouvoir préciser les besoins en Data Quality Management. Et c’est une bonne chose, selon moi, car votre action sera mieux comprise et soutenue par l’organisation, si elle alignée avec les enjeux de chacun.

Par quoi commencer ?

Le diable étant dans les détails, vous vous rendrez bien vite compte que vous êtes loin d’en avoir fini. En effet, vous aurez noté que derrière ces quatre objectifs, il vous faudra composer avec un volume conséquent de données, à collecter dans pratiquement l’ensemble des services de l’entreprises.

Alors que faire ? Prioriser bien sûr, et choisir ses combats. On prendra pour postulat que le principe de Pareto s’applique à notre cas (vous me pardonnerez le raccourci), et qu’en résolvant 20% des problèmes de qualité de données, on aura fait 80% du chemin.

Le DMBOK vous recommande de focaliser sur les données critiques (qui sont nécessairement liées aux objectifs prioritaires de l’entreprise), dixit : l’expérience client, l’efficacité et l’efficience de l’organisation. Et vous les trouverez probablement au sein d’une de ces quatre thématiques :

- Les rapports réglementaires, financiers ou de gestion,

- Les besoins opérationnels de l’entreprise,

- La mesure de la qualité des produits et de la satisfaction client,

- La stratégie commerciale, et en particulier les efforts pour se différencier de la concurrence.

Pensez aux données de référence et aux données maîtres (Master Data) qui sont généralement critiques par essence, car liées à des processus prioritaires de la société. Vous aurez noté que le DMBOK consacre une de ses « fonctions » spécifiquement à ce sujet. Cela n’est pas sans raison.

Les dimensions de la Data Quality...

Rendus à ce point, vous aurez besoin de mesurer la qualité des données au travers de dimensions mesurables et explicites pour les processus Métier : on parlera ici de validité, de complétude, d’exactitude, d’unicité, de cohérence, etc.

Il y’a beaucoup à écrire à ce sujet. D’ailleurs dans mon précédent article (déjà cité), je vous ai donné les dimensions nécessaires vues par la norme ISO 8 000 (i.e. norme internationale spécifiquement dédiée à la qualité des données).

Le DMBOK fait référence à la norme ISO 8 000, mais aussi au framework de Wong-Wang (15 dimensions à suivre tout de même !), et à d’autres auteurs ayant proposé un panel de dimensions relatives à la qualité des données.

Sans se contredire sur le fond, ces référentiels ne sont pas d’accord pour l’ensemble des dimensions à mettre en place et à suivre. Vous devrez faire vos propres arbitrages. Je n’en dirai pas plus sur les dimensions mises en avant par le DMBOK : nous consacrerons un prochain article complet sur le sujet.

Les règles Métier afférentes

Bien. Il vous reste désormais, le sujet le plus complexe à traiter.

Il vous faut identifier les règles Métier qui décrivent, ou impliquent des attendus, pour vos dimensions de la Data Quality. Je vous épargne la liste complète des problèmes et difficultés que relève le DMBOK. Elle est malheureusement longue et très crédible. On notera en particulier que :

- Les règles Métier ne sont la plupart du temps pas explicitement documentées ; Elles nécessitent du reverse engineering des processus Métier, de la règlementation, du code informatique, etc.

- La correspondance entre les règles Métier et les dimensions de la Data Quality n’est pas triviale. C’est bien souvent la combinaison de plusieurs règles et mesures qui va vous permettre de reconstituer une dimension comme la Validité ou l’Intégrité des données.

- Définir les règles de la Data Quality est un défi, car la plupart des équipes Métier ne raisonnent pas en termes de règles quand elles évoquent la Data. Il vous faudra identifier les entrées et les sorties du processus Métier, les conséquences si une donnée est manquante ou erronées, et en fin de compte, ce qu’est une donnée de mauvaise qualité pour le processus concerné.

- Les équipes Métier ne pensent pas à tout, et ne sont jamais exhaustives si le processus Métier est complexe et transverse à plusieurs services. Elles vont oublier de vous signaler des relations et des dépendances entre plusieurs champs, des règles à appliquer ou à vérifier, des problèmes connus de non-qualité, etc.

Vous allez très vite vous rendre compte que cet exercice est une vraie source de tension entre le Métier (qui connait les processus Métier, et peut définir ce qu’est une donnée de qualité) et l’IT (la plupart du temps en charge de coder les règles techniques de vérification). Il va vous falloir une équipe déterminée, méticuleuse et diplomate, de Data Analysts et de Data Managers.

Et si vous n’avez pas un outillage intelligent, capable d’explorer vos jeux de données pour retrouver seul des anomalies ou des règles implicites que le Métier aurait omis de vos mentionner, cela restera compliqué. Bien sûr cet outillage devra aussi vous permettre d’itérer facilement avec les équipes Métier et IT, en visualisant dans leur contexte les anomalies trouvées.

Et bien là, j’ai plutôt une bonne nouvelle. Car cet outillage existe. Nous l’avons créé, forts de notre expérience et des enjeux clients auxquels nous avons été confrontés. Et je vous invite à nous contacter pour en savoir plus sur notre solution Data Quality AI.

Une analyse itérative

Pour définir votre plan d’action de remédiation, il vous faudra faire une analyse approfondie des données critiques des processus prioritaires, et valider vos résultats avec les équipes Métier et IT. Puis raffiner ces analyses, jusqu’à ce que toutes les zones d’ombre aient été levées :

- Les données réelles sont-elles conformes à ce qu’on vous a dit, ou a ce qui est prévu par les processus ? On a souvent hélas une vision erronée et avantageuse de la situation.

- Est-ce que les règles implicites que vous avez trouvées méritent une attention particulière ? Lèvent-elles le voile sur des problèmes non encore identifiés par le Métier ?

- A quel type d’anomalies est-on confronté et quel est le niveau de non-conformité ? Quelle est la priorité de chaque anomalie au regard des enjeux Métier ? Il vous faut quantifier l’effort de remédiation.

- Quelles sont les causes premières (root cause) de chaque anomalie ? Il ne sert à rien aux Danaïdes de remplir leur tonneau ; et il serait absurde de corriger des anomalies susceptibles de revenir sans cesse. Les causes premières impliquent-elles un changement de processus ? une modification du code applicatif ? une formation/sensibilisation des utilisateurs ?

Quand vous aurez fait tout cela, j’oserais presque vous dire que vous avez fait les trois quarts du chemin. Bien sûr il vous reste à appliquer votre plan d’action, mesurer et monitorer l’évolution de la qualité de données dans le temps (qui doit nécessairement s’améliorer si vous avez fait les bons choix). Mais il ne s’agit ici que d’exécution.

J’en resterai donc là pour le contenu de cet article. Je rédigerai la suite prochainement en développant en particulier les risques et les écueils à éviter pour la remédiation des erreurs.

Conclusion

Le point essentiel à retenir, est qu’il est prématuré de se lancer dans du Data Quality Management, sans avoir déterminé les enjeux Métier prioritaires et les données critiques qui y sont associés. Par ailleurs, il vous faut aussi vulgariser et valider votre plan d’action, non seulement avec la Direction, mais également avec les équipes opérationnelles impliquées (qui ne seront dès lors plus des freins, mais des accélérateurs de votre démarche).

Pour être écouté (et crédible), soyez factuel. Vous devez quantifier l’impact de la non-qualité des données critiques, en termes de risques financiers, règlementaires ou d’image pour l’entreprise. L’information doit être parlante pour tous et permettre un arbitrage consensuel. Il vous faut aussi déterminer une échelle de criticité pour (ré)évaluer la priorité des données critiques à l’instant « t », et au cours du temps.

Selon le même principe, les dimensions associées à la mesure de la Data Quality, les mesures et règles afférentes, doivent porter sur ces données critiques et avoir du sens pour l’ensemble des parties prenantes.

La définition de votre plan d’action passe nécessairement par une analyse minutieuse et itérative de ces données critiques, liées aux processus Métier prioritaires. Et il vous faudra pour cela, non seulement une équipe aguerrie de Data Analysts et de Data Managers, mais également un outillage puissant pour vous aider à trouver et visualiser toutes les anomalies, qu’elles soient déjà, ou non, identifiées et connues par le Métier. Si vous n’êtes pas équipés, pourquoi ne pas vous intéresser alors à notre solution Data Quality AI ?

Place ensuite à la remédiation des erreurs. Un sujet que nous développerons dans un prochain article !